Introducción a Goose, el agente de IA en tu máquina

Introducción

En enero de 2025, Block presentó Goose, un agente de IA extensible, de código abierto, distribuido como una interfaz de línea de comandos (CLI) y una aplicación de escritorio. A diferencia de los asistentes de código simples, Goose va más allá de las sugerencias: ejecuta comandos de shell, edita archivos, ejecuta código y orquesta flujos de trabajo de varios pasos de forma autónoma. Goose se ejecuta localmente, se conecta a diferentes proveedores de modelos de lenguaje grandes LLM y extiende sus capacidades a través de servidores Model Context Protocol (MCP).

Desde su lanzamiento inicial, Goose ha evolucionado significativamente. El proyecto ahora soporta más de 25 proveedores LLM, incluyendo servicios comerciales, plataformas en la nube y modelos locales. En diciembre de 2025, Block contribuyó Goose a la Agentic AI Foundation (AAIF) de la Linux Foundation, junto con MCP de Anthropic y AGENTS.md de OpenAI, asegurando que el futuro del proyecto sea moldeado por la comunidad bajo una gobernanza neutral.

En este artículo, te guiaré a través de la configuración de Goose CLI en Linux y macOS, conectarlo a Google Gemini y extender sus capacidades utilizando un servidor MCP.

Configuración de Goose CLI

El CLI de Goose es una herramienta ligera que te permite interactuar directamente con Goose desde tu terminal. Prefiero usar el CLI porque proporciona una forma simple y eficiente de interactuar con el modelo de IA sin necesidad de una interfaz gráfica de usuario.

Primero, descarga e instala el CLI de Goose. La guía de inicio proporciona instrucciones de instalación para varios sistemas operativos.

Para Linux, instala la última versión de Goose usando:

curl -fsSL https://github.com/block/goose/releases/download/stable/download_cli.sh | bashEste script descarga e instala la última versión de Goose para tu distribución.

Importante

Considera verificar la fuente y el checksum del script antes de ejecutarlo para seguir las mejores prácticas de seguridad.

Como alternativa, visita la página de GitHub releases para descargar el binario adecuado para tu sistema operativo.

Para usuarios de macOS, Goose también está disponible a través de Homebrew:

brew install block-goose-cliUna vez instalado, puedes actualizar Goose en cualquier momento ejecutando:

goose updateConfiguración del proveedor LLM (Google Gemini)

A continuación, configura Goose para un proveedor LLM. Goose ahora soporta más de 25 proveedores diferentes en tres categorías principales:

- Proveedores basados en API: Anthropic (Claude), OpenAI, Google Gemini, xAI (Grok), Mistral AI, y más

- Plataformas en la nube: Amazon Bedrock, GCP Vertex AI, Azure OpenAI, Databricks, Snowflake

- Proveedores locales: Ollama, Ramalama, Docker Model Runner (completamente gratis, se ejecuta en tu máquina)

- CLI pass-through: Claude Code, OpenAI Codex, Cursor Agent, Gemini CLI (usa tus suscripciones existentes)

Para este ejemplo, usaré Gemini API, el proveedor LLM de Google. Elegí esta opción porque ofrece una capa gratuita con límites de uso generosos, lo que permite experimentar sin incurrir en costes.

Esta es la forma más rápida de empezar con Goose. No obstante, es posible que necesites cambiar de proveedor o actualizar a un plan de pago si alcanzas los límites de uso.

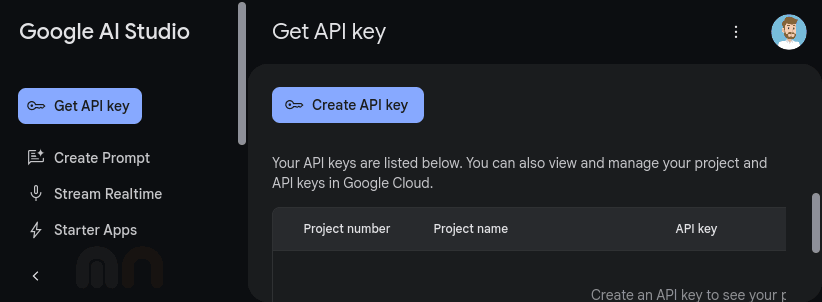

Para conectarte a Google Gemini, necesitas crear una cuenta de Google y obtener una API key. Puedes generar esta clave en Google AI Studio:

Presiona el botón "Create API Key" para generar una nueva API key.

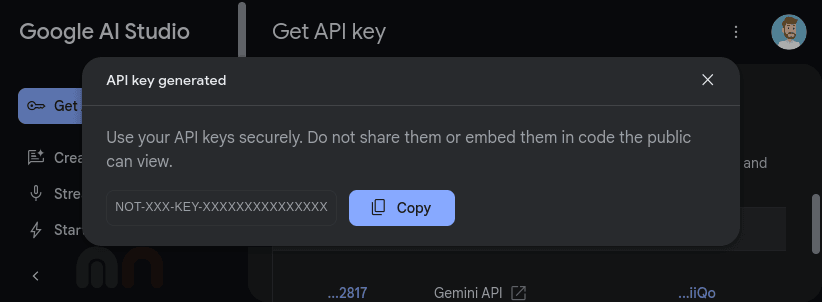

Utilizaremos esta API key para configurar Goose y conectarnos a Google Gemini estableciendo el proveedor de Goose. Puedes hacerlo ejecutando el siguiente comando:

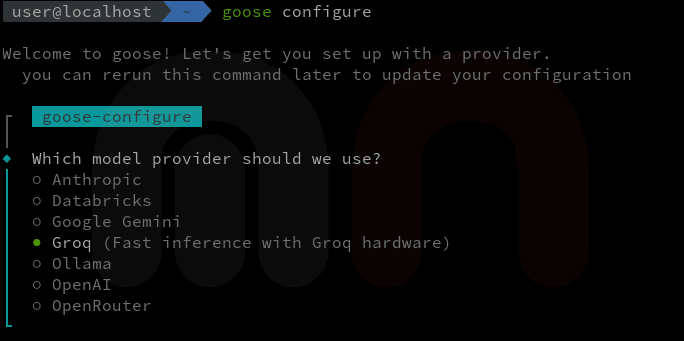

goose configureEl comando goose configure te guiará a través de la configuración del proveedor, incluyendo la introducción de tu API key y la selección del modelo predeterminado.

Si la configuración es exitosa, verás un mensaje de confirmación.

Si encuentras algún problema, verifica tu API key, la conexión a Internet o las trazas en tu directorio ~/.config/goose para obtener más información.

Ahora que Google Gemini está configurado como nuestro proveedor LLM, exploremos las capacidades de Goose iniciando una nueva sesión de chat.

Ejecutar Goose por primera vez

Inicia una nueva sesión ejecutando el siguiente comando:

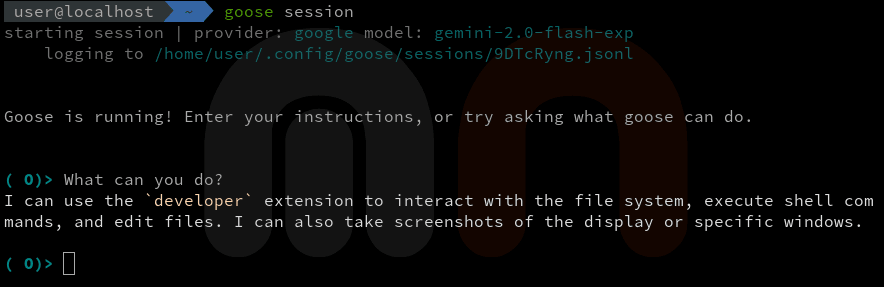

goose sessionEste comando lanza una sesión de chat basada en terminal donde puedes interactuar con el LLM.

En la imagen anterior, puedes ver la sesión de Goose ejecutándose en la terminal. En este caso, le pedí al modelo que enumerara sus capacidades, y respondió con una lista de los comandos admitidos.

Goose también incluye varios comandos slash integrados que puedes usar durante una sesión:

/prompts- Listar los prompts disponibles/prompt- Usar un prompt específico/compact- Compactar el historial de la conversación/clear- Limpiar la conversación

Configuración del servidor MCP de Playwright

El ecosistema MCP ha crecido significativamente desde el lanzamiento inicial de Goose, con más de 3.000 servidores MCP ahora disponibles cubriendo herramientas de desarrollo, suites de productividad y servicios especializados.

Para demostrar la extensibilidad de Goose, configuremos el servidor MCP de Playwright de Microsoft.

Este servidor permite la automatización del navegador utilizando el árbol de accesibilidad de Playwright, haciéndolo rápido y amigable para LLMs sin necesidad de modelos de visión.

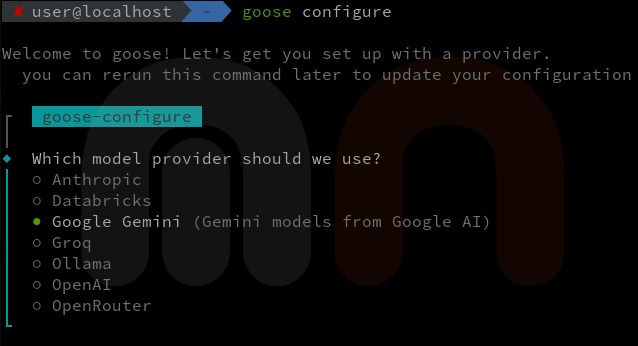

Puedes configurarlo a través de la línea de comandos o editando tu archivo goose/config.yaml.

Para este ejemplo, usaremos la línea de comandos:

goose configureEl CLI te pedirá que configures Goose:

This will update your existing config file

if you prefer, you can edit it directly at /home/user/.config/goose/config.yaml

┌ goose-configure

│

◆ What would you like to configure?

│ ○ Configure Providers (Change provider or update credentials)

│ ○ Toggle Extensions

│ ● Add Extension

└Selecciona Add Extension, elige Command-line Extension e introduce los siguientes detalles para el servidor MCP de Playwright:

┌ goose-configure

│

◇ What would you like to configure?

│ Add Extension

│

◇ What type of extension would you like to add?

│ Command-line Extension

│

◇ What would you like to call this extension?

│ playwright

│

◇ What command should be run?

│ npx @playwright/mcp@latest

│

◇ Please set the timeout for this tool (in secs):

│ 300

│

◇ Enter a description for this extension:

│ Playwright

│

◇ Would you like to add environment variables?

│ No

│

└ Added playwright extensionUna vez que hayas añadido la extensión del servidor MCP de Playwright, puedes iniciar una nueva sesión e interactuar con él a través de Goose.

Nota

Para ejecutar esta extensión, necesitas tener Node.js instalado en tu sistema. Playwright descargará automáticamente los binarios del navegador necesarios en el primer uso.

Usar Goose para abrir un navegador e ir a un sitio web

Para demostrar las capacidades de Goose con el servidor MCP de Playwright, lo usaremos para abrir un navegador e ir a un sitio web. Puedes hacerlo ejecutando el siguiente comando en la sesión de Goose:

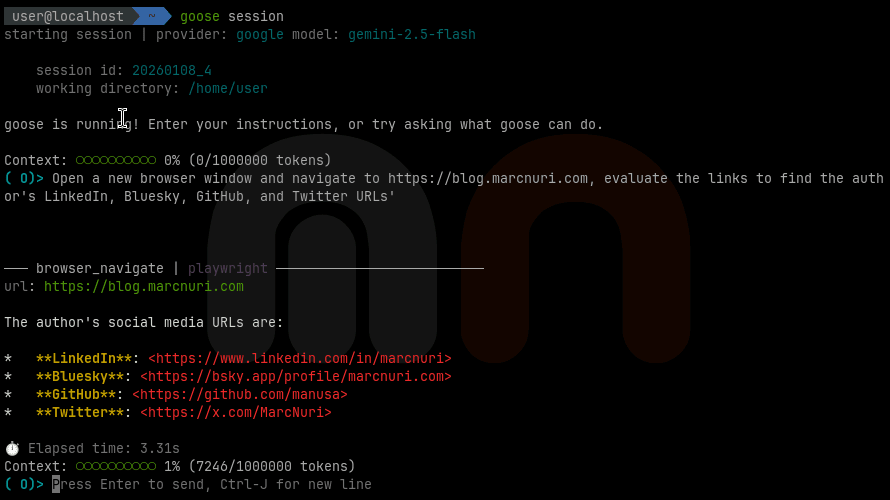

goose sessionUna vez se haya iniciado la sesión, puedes interactuar con el servidor MCP de Playwright escribiendo el siguiente comando:

Open a new browser window and navigate to https://blog.marcnuri.com, evaluate the links to find the author's LinkedIn, Bluesky, GitHub, and Twitter URLs'Goose abre una ventana del navegador, navega al sitio web y analiza el árbol de accesibilidad de la página. Luego extrae las URL de LinkedIn, Bluesky, GitHub y Twitter del autor y las muestra.

En la imagen anterior, puedes ver la sesión de Goose con el servidor MCP de Playwright ejecutándose en la terminal.

Después de enviar el prompt, Goose ejecutó estos pasos:

- Goose envía mi prompt y las herramientas disponibles al LLM.

- El LLM responde con acciones de Playwright, y Goose las ejecuta:

- Abre una ventana del navegador.

- Navega al sitio web.

- Escanea el snapshot de accesibilidad de la página buscando enlaces de redes sociales.

- Goose envía los resultados al LLM para su interpretación.

- Goose muestra la respuesta final.

En este caso, interactuó con un único servidor MCP, pero puedes añadir varios servidores para ampliar aún más las capacidades de Goose.

Goose también soporta MCP Apps, que permiten interfaces de usuario ricas e interactivas en lugar de respuestas solo de texto. Esto permite que las extensiones proporcionen formularios interactivos, visualizaciones de datos y asistentes de configuración directamente dentro de la sesión de Goose.

Consejo

Si estás interesado en crear tus propios servidores MCP, consulta las guías para conectarte a servidores MCP usando LangChain4j (Java) o LangChain.js.

Automatización de flujos de trabajo con Recipes

Además de los servidores MCP, Goose introduce Recipes (recetas), una forma poderosa de empaquetar y compartir flujos de trabajo de IA reutilizables. Una receta es un archivo YAML que agrupa instrucciones, extensiones requeridas, parámetros e incluso lógica de reintento en una configuración compartible.

Aquí tienes una receta simple que genera un informe de estado semanal:

version: "1.0.0"

title: Weekly Status Report

description: Generate a summary of work completed this week

instructions: |

Analyze the git history and open issues to create a brief status report.

Focus on commits from the past 7 days.

extensions:

- developer

activities:

- What did I accomplish this week?

- Summarize my commits since MondayEjecuta una receta desde el CLI:

goose run --recipe weekly-report.yamlLas recetas pueden incluir parámetros para entrada dinámica, lógica de reintento para validación automatizada y sub-recetas para componer flujos de trabajo complejos. También puedes programar recetas para que se ejecuten automáticamente usando expresiones cron:

goose schedule add --schedule-id daily-report --cron "0 9 * * *" --recipe-source ./recipes/daily-report.yamlLa comunidad de Goose ha creado un OSS Skills Marketplace donde puedes descubrir y compartir recetas y extensiones. Esto facilita el arranque de flujos de trabajo comunes sin tener que empezar desde cero.

Uso de un proveedor LLM alternativo (Groq)

Una de mis características favoritas de Goose es su capacidad para conectarse a diferentes proveedores LLM. Hasta ahora, hemos utilizado Google Gemini porque se puede acceder de forma gratuita, pero es posible que desees cambiar a un proveedor diferente por diversas razones.

Consejo

Si prefieres mantener todo local y gratuito, considera usar Ollama con Goose.

Simplemente instala Ollama, ejecuta un modelo de lenguaje pequeño como ollama run qwen2.5, y configura Goose para usarlo.

Esto te da privacidad completa y sin límites de uso, aunque requiere una máquina capaz.

Con MCP, incluso los modelos más pequeños pueden alcanzar un rendimiento de nivel experto en tareas especializadas.

Intentemos conectarnos a Groq, un potente proveedor LLM que ofrece una amplia gama de modelos y capacidades y es conocido por su velocidad y eficiencia. La arquitectura única de Language Processing Unit (LPU) de Groq ofrece un alto rendimiento con un consumo mínimo de energía, lo que lo hace ideal para tareas de IA en tiempo real.

Groq también ofrece una capa gratuita, pero su límite de tasa de tokens por minuto puede ser demasiado restrictivo para algunos casos de uso. Esto es especialmente cierto para los servidores MCP que requieren una interacción continua con el proveedor LLM.

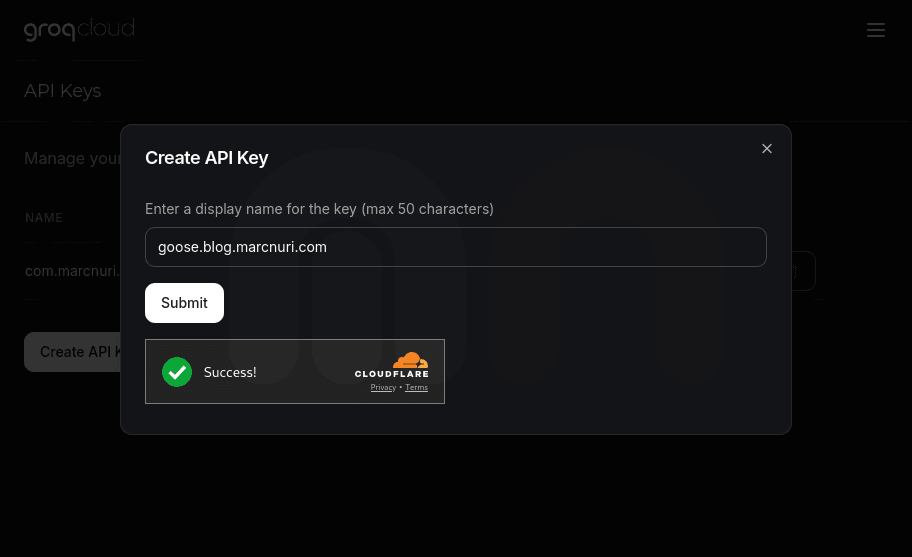

Para conectar Goose a Groq, debes crear una cuenta en el sitio web de Groq y obtener una API key. Puedes generar esta clave en la Groq cloud console:

Utilizaremos esta API key para configurar Goose y conectarlo a Groq estableciendo Groq como proveedor predeterminado. Puedes hacerlo ejecutando el siguiente comando:

goose configureEl comando goose configure te guiará a través de la configuración del proveedor, incluyendo la introducción de tu API key y la selección del modelo predeterminado.

Con un simple comando, puedes cambiar entre diferentes proveedores LLM y explorar sus capacidades con Goose. Ahora es muy fácil utilizar una variedad de modelos y servicios de IA aprovechando sus fortalezas específicas sin tener que cambiar entre diferentes herramientas o interfaces.

Nota

Para un ejemplo práctico de uso de Groq con Goose, consulta cómo ejecutar DeepSeek-R1 con Goose usando Groq como proveedor.

Goose vs Claude Code vs Cursor

Con tantos agentes de IA disponibles, te preguntarás cómo se compara Goose con alternativas comerciales como Claude Code y Cursor.

| Característica | Goose | Claude Code | Cursor |

|---|---|---|---|

| Precio | Gratis (código abierto) | $20-200/mes | $20-200/mes |

| Flexibilidad de modelos | Cualquier LLM (25+ proveedores) | Solo modelos Claude | Selección limitada |

| Ejecución local | Sí | No (nube) | Parcial |

| Soporte MCP | Nativo | Sí | Limitado |

| Recipes/flujos de trabajo | Sí (basado en YAML) | No | No |

| Integración IDE | CLI + Escritorio | CLI | IDE completo |

| Código abierto | Sí (Apache 2.0) | No | No |

Cuándo elegir Goose: Quieres un agente gratuito, totalmente de código abierto, con flexibilidad total de modelos, automatización de flujos de trabajo mediante Recipes y sin dependencia de un proveedor.

Cuándo elegir Claude Code: Prefieres una experiencia pulida y lista para usar con los potentes modelos Claude de Anthropic y no te importa el coste de suscripción.

Cuándo elegir Cursor: Quieres una integración profunda con el IDE con autocompletado y sugerencias en línea potenciadas por IA en lugar de un agente independiente.

Preguntas frecuentes

¿Es Goose completamente gratis?

Sí. Goose es de código abierto bajo la licencia Apache 2.0 sin cuotas de suscripción. Sin embargo, necesitarás acceso a un proveedor LLM. Puedes usar una capa gratuita (Google Gemini, Groq), una API de pago, o ejecutar modelos localmente con Ollama para una configuración completamente gratuita.

¿Cuál es la diferencia entre Goose y Claude Code?

Goose es agnóstico en cuanto a modelos y se ejecuta localmente, mientras que Claude Code está vinculado a los modelos de Anthropic y se ejecuta en la nube. Goose también ofrece Recipes para automatización de flujos de trabajo y soporta más de 25 proveedores LLM. Claude Code proporciona una experiencia más pulida lista para usar, pero cuesta entre $20-200/mes.

¿Puedo usar Goose sin conexión?

Sí, combinando Goose con un proveedor LLM local como Ollama o Docker Model Runner. Esto te da privacidad completa y sin límites de uso.

¿Qué son los servidores MCP y los necesito?

Los servidores MCP (Model Context Protocol) extienden las capacidades de Goose conectándolo a herramientas y servicios externos. Son opcionales pero potentes. Puedes añadir capacidades como automatización del navegador, integración con GitHub o gestión de Kubernetes sin escribir código personalizado.

Conclusión

En este artículo, presenté Goose, un agente de IA de código abierto que se ejecuta localmente, se conecta a más de 25 proveedores LLM incluyendo Google Gemini y Groq, y extiende sus capacidades a través de servidores MCP y Recipes. Demostré cómo configurar Goose, configurar Google Gemini, utilizar el servidor MCP de Playwright para la automatización del navegador y automatizar flujos de trabajo con Recipes.

Desde su lanzamiento en enero de 2025, Goose ha madurado significativamente. El proyecto ha visto más de 110 lanzamientos, ha ganado más de 30.000 estrellas en GitHub y ha atraído a más de 350 colaboradores. El ecosistema MCP se ha expandido a más de 3.000 servidores cubriendo herramientas de desarrollo (GitHub, VS Code, Docker), suites de productividad (Google Drive, Asana, Slack) y servicios especializados como el Kubernetes MCP Server.

Un hito importante llegó en diciembre de 2025 cuando Block contribuyó Goose a la Agentic AI Foundation de la Linux Foundation, junto con MCP de Anthropic y AGENTS.md de OpenAI. Esto asegura que el desarrollo de Goose continúe bajo una gobernanza neutral impulsada por la comunidad con el respaldo de AWS, Anthropic, Google, Microsoft, OpenAI y otros líderes de la industria.

A medida que el ecosistema de IA agéntica continúa evolucionando, Goose se presenta como una base sólida para los desarrolladores que buscan automatizar flujos de trabajo potenciados por IA manteniendo el control total sobre su entorno local. Este cambio hacia desarrolladores basados en máquinas está remodelando cómo pensamos sobre las herramientas y flujos de trabajo de desarrollo.

Consejo

Para descubrir cómo los agentes de línea de comandos como Goose pueden mejorar drásticamente la productividad del desarrollador, consulta cómo impulsé mi productividad con IA en 2025.